Da immer mehr Unternehmen mit der Entwicklung von KI-Agenten experimentieren, steigt die Notwendigkeit, deren Qualität zu gewährleisten, täglich. Das Testen von KI ist einzigartig und erfordert zusätzliche Kenntnisse und Fähigkeiten, die für diesen Bereich spezifisch sind.

Dieser Artikel befasst sich mit den Testansätzen, die sicherstellen, dass KI-Agenten effektiv arbeiten. Außerdem wird erörtert, wie sich Testmethoden am besten kombinieren lassen, um optimale Ergebnisse zu erzielen. Egal, ob Sie neu im Bereich KI sind oder ein erfahrener Experte, dieser Leitfaden wird Ihnen helfen zu verstehen, wie Sie KI effektiv testen können.

Testbedarf von AI-Agenten

KI-Agenten sind Softwareprogramme, die wie Menschen denken und handeln können. Sie verstehen Sprache, erkennen Bilder, treffen Entscheidungen und lernen aus Erfahrungen. Man sieht sie an vielen Stellen:

- Chatbots: Diese Agenten können Ihre Fragen auf Websites oder in Apps beantworten.

- Virtuelle Assistenten: Agenten wie Siri, Alexa und Google Assistant können Ihnen bei Aufgaben helfen.

- Empfehlungssysteme: Agenten schlagen vor, welche Produkte man kaufen oder welche Filme man sehen sollte.

- Autonome Fahrzeuge: Selbstfahrende Autos nutzen KI-Agenten, um auf den Straßen zu navigieren.

Da KI-Agenten immer häufiger eingesetzt werden und immer leistungsfähiger sind, ist es von entscheidender Bedeutung, sie gründlich zu testen. Herkömmliche Tests reichen für KI-Agenten möglicherweise nicht aus, und sie erfordern einen besonderen Ansatz. KI muss den Industriestandards entsprechen, was aufgrund ihrer einzigartigen Eigenschaften schwierig sein kann:

- Lernen und Anpassen: KI-Agenten können ihr Verhalten ändern, wenn sie aus neuen Daten lernen. Häufige Tests sind erforderlich, um sicherzustellen, dass sie weiterhin korrekt arbeiten.

- Entscheidungen treffen: KI-Agenten treffen oft Entscheidungen, die sich auf das Leben der Menschen auswirken. Wir müssen diese Entscheidungen testen, um zu prüfen, ob sie fair, genau und unvoreingenommen sind.

- Verstehen von Sprache: Einige KI-Agenten verwenden natürliche Sprachverarbeitung (NLP), um menschliche Sprache zu verstehen. Wir müssen also testen, wie gut sie verschiedene Akzente, Slang und Grammatik verstehen.

- Argumentation und Logik: KI-Agenten verwenden komplexe Logik. In diesem Fall sollten wir prüfen, ob die Logik und die Schlussfolgerungen korrekt sind.

Kurzum, wir müssen KI-Agenten gründlich testen, um ihre Zuverlässigkeit, Sicherheit und Leistung zu gewährleisten. Dies wird Unternehmen und Nutzern helfen, ihnen nicht nur zu vertrauen, sondern sich auch auf sie verlassen zu können.

Manuelle Tests für AI-Agenten

Manuelles Testen bedeutet, dass echte Menschen den KI-Agenten prüfen, um zu sehen, wie er funktioniert. Diese Tester interagieren direkt mit dem KI-Agenten, probieren verschiedene Szenarien aus und suchen nach möglichen Problemen. Trotz all der neuen Tools für automatisierte Tests sind manuelle Tests für KI-Agenten nach wie vor entscheidend. Hier ist der Grund dafür:

- Verstehen der Benutzererfahrung. KI-Agenten sind oft für die Interaktion mit Menschen konzipiert. Durch manuelle Tests können wir feststellen, wie einfach und natürlich sich diese Interaktionen anfühlen. Menschliche Tester können Dinge beurteilen wie:

- Ist es einfach, mit dem Agenten zu sprechen?

- Versteht es, was der Nutzer will?

- Ist die Interaktion reibungslos und hilfreich?

- Unerwartete Probleme aufspüren. KI-Agenten können manchmal ein unerwartetes Verhalten zeigen, insbesondere wenn sie mit neuen oder ungewöhnlichen Situationen konfrontiert werden. Menschliche Tester sind sehr gut darin, diese Art von “Überraschungen” zu finden, weil sie es können:

- Probieren Sie Dinge aus, die automatisierte Tests möglicherweise übersehen.

- Nutzen Sie ihre Intuition und Kreativität, um das Verhalten des Agenten zu erkunden.

- Identifizieren Sie Probleme, die sich nur schwer mit strengen Regeln definieren lassen.

- Subjektive Qualitäten bewerten. Einige der wichtigsten Eigenschaften eines KI-Agenten lassen sich mit Testsoftware nur schwer messen. Ist der Agent zum Beispiel höflich, freundlich oder einfühlsam? Menschliche Tester können uns wertvolles Feedback zu diesen subjektiven Aspekten geben. Kurz gesagt, manuelle Tests bieten eine menschliche Note, die automatisierte Tests nicht ersetzen können.

Automatisierte Tests für AI-Agenten

Bei automatisierten Tests werden spezielle Software-Tools und Skripte verwendet, um vordefinierte Testfälle automatisch auszuführen. Anstatt dass manuelle Tester Schritte ausführen, Daten eingeben und Ergebnisse überprüfen, führen Automatisierungswerkzeuge diese Aktionen aus, um erwartete und tatsächliche Ergebnisse zu vergleichen. Dies wird immer wichtiger, da KI-Agenten immer komplexer werden und häufige Tests erfordern. Hier sind einige der wichtigsten Vorteile automatisierter Tests für KI-Agenten:

- Geschwindigkeit und Effizienz. Automatisierte Tests laufen viel schneller als manuelle Tests. Sie können außerdem rund um die Uhr laufen und ermöglichen häufigere Tests.

- Konsistenz und Verlässlichkeit. Automatisierte Tests tun jedes Mal dasselbe, was hilft, Fehler zu vermeiden und Zuverlässigkeit zu gewährleisten.

- Skalierung und Abdeckung. Automatisierte Tests lassen sich leicht skalieren, um zahlreiche Szenarien zu testen, die einen breiteren Bereich der Funktionalität des KI-Agenten abdecken. Dies ist besonders wichtig für komplexe KI-Agenten mit vielen Funktionen.

- Frühzeitige Erkennung von Problemen. Automatisierte Tests können bei jeder Änderung am KI-Agenten durchgeführt werden und ermöglichen so eine frühzeitige Erkennung potenzieller Probleme. Automatisierte Tests ermöglichen es den Entwicklern, Probleme zu erkennen und zu beheben, bevor sie zu großen Problemen werden.

- Kosteneffizienz. Die Einrichtung automatisierter Tests ist zwar mit anfänglichen Kosten verbunden, kann aber langfristig Geld sparen, da der Bedarf an manuellen Tests sinkt und Probleme früher erkannt werden.

Zusammenfassend lässt sich sagen, dass automatisierte Tests eine leistungsstarke Methode sind, um sicherzustellen, dass KI-Agenten gründlich und effizient getestet werden. Sie bietet Geschwindigkeit, Skalierbarkeit und Konsistenz, die für die moderne Softwareentwicklung unerlässlich sind.

Wichtige Testkonzepte für AI-Agenten

Um KI-Agenten effektiv testen zu können, ist es wichtig, die grundlegenden Prinzipien des Softwaretests zu verstehen. Diese Konzepte helfen uns, unsere Tests zu planen, die Effektivität des Agenten zu messen und sicherzustellen, dass wir ihn gründlich getestet haben.

- Testfälle. Ein Testfall ist ein spezifischer Satz von Aktionen, die wir durchführen, um zu prüfen, ob der KI-Agent korrekt funktioniert. Jeder Testfall hat:

- Eine Beschreibung dessen, was wir tun werden

- Die Schritte, die wir befolgen werden

- Was wir von dem KI-Agenten erwarten

Ein Testfall für einen Chatbot könnte zum Beispiel so aussehen: “Der Benutzer fragt ‘Wie ist das Wetter heute? Prüfen Sie, ob der Chatbot das richtige Wetter für den Standort des Benutzers angibt.”

- Testabdeckung. Sie gibt an, in welchem Umfang die Tests verschiedene Teile oder Aspekte des KI-Agenten überprüft haben. Auf diese Weise lässt sich die Vollständigkeit unserer Tests messen. Eine gute Testabdeckung (etwa 80 %) bedeutet, dass wir viele Teile des Agenten in verschiedenen Situationen getestet haben. Es gibt verschiedene Möglichkeiten, die Testabdeckung zu messen, z. B:

- Haben wir alle Hauptfunktionen des Agenten getestet?

- Haben wir den Agenten mit verschiedenen Arten von Eingaben getestet?

- Haben wir das Mittel in verschiedenen Umgebungen getestet?

- Testdaten. KI-Agenten lernen anhand von Daten, weshalb die für ihre Tests verwendeten Testdaten eine entscheidende Komponente darstellen. Wir müssen verschiedene Testdatensätze verwenden, um sicherzustellen, dass der Agent in verschiedenen Situationen gut funktioniert. Diese Testdaten sollten Folgendes umfassen:

- Korrekte Daten

- Falsche Daten

- Grenzfälle (ungewöhnliche oder seltene Situationen)

- Daten, die der realen Nutzung entsprechen

- Testergebnisse und Testresultate. Nachdem wir unsere Tests durchgeführt haben, müssen wir die Testergebnisse sorgfältig prüfen:

- Hat der KI-Agent die erwartete Leistung erbracht?

- Hat sie die richtige Antwort gegeben?

- Hat sie die richtige Entscheidung getroffen?

- Fehlschläge im Test. Wenn der KI-Agent nicht wie erwartet funktioniert, sprechen wir von einem Testfehler. Es ist wichtig, diese Testfehler zu verfolgen, die Probleme zu beheben und dann erneut zu testen, um sicherzustellen, dass die Probleme behoben sind. Wenn wir diese Schlüsselkonzepte verstehen, können wir effektivere Tests entwerfen und besser verstehen, wie gut unsere KI-Agenten arbeiten.

Vergleich der Testansätze

Manuelle und automatisierte Tests spielen eine entscheidende Rolle bei der Sicherstellung der korrekten Funktion von KI-Agenten. Jeder Testansatz hat seine Stärken und Schwächen. Manuelle Tests bieten den Einblick und die Flexibilität eines QA-Ingenieurs, während automatisierte Tests Geschwindigkeit, Konsistenz und Skalierbarkeit bieten. Die Wahl des richtigen Testansatzes (oder einer Kombination von Methoden) hängt von den spezifischen Anforderungen des KI-Agenten ab. Hier ist ein Vergleich dieser beiden Ansätze:

Manuelle vs. automatisierte Tests für KI-Agenten

Geschwindigkeit

Langsam (Minuten/Test)

Schnell (Millisekunden/Test)

Kosten

Höhere laufende Kosten (70-80% des Testbudgets)

Höhere Anfangskosten (30-50% des Testbudgets), niedrigere laufende Kosten (20-30% des Testbudgets)

Konsistenz

Unter

Höher

Skalierbarkeit

Gering (linearer Anstieg des Aufwands bei mehr Tests)

Sehr hoch (Aufwand steigt sublinear mit mehr Tests)

Erfassungsbereich

Begrenzt

Umfassender

Am besten für

Benutzerfreundlichkeit, explorative Tests, komplexe Szenarien und subjektive Bewertungen

Sich wiederholende Aufgaben, Regressionstests, Leistungstests und Tests in großem Maßstab

Mögliche Probleme

Menschliche Fehler, zeitaufwändig und nicht leicht skalierbar

Begrenzt auf vordefinierte Tests, weniger flexibel und hohe Anfangsausstattung

In vielen Fällen besteht die effektivste Teststrategie darin, manuelle und automatisierte Tests zu kombinieren. Sie können zusammenarbeiten, um eine vollständigere und praktischere Bewertung des KI-Agenten zu ermöglichen.

Spezifische Prüftechniken für KI-Agenten

Da sich KI-Agenten von normaler Software unterscheiden, müssen wir spezielle Werkzeuge und Testverfahren einsetzen. Diese Techniken helfen uns, die einzigartigen Fähigkeiten von KI-Agenten in den Bereichen Lernen, Entscheidungsfindung und Sprachverständnis zu bewerten. Hier sind einige wichtige Testtechniken für KI-Agenten:

- Regressionstests. KI-Agenten können sich weiterentwickeln, während sie lernen. Daher muss sichergestellt werden, dass neue Änderungen nicht zu einer Beeinträchtigung bestehender Funktionen führen. Bei Regressionstests werden bereits durchgeführte Tests erneut ausgeführt, um zu überprüfen, ob alles noch wie erwartet funktioniert. Dieser Prozess ist Teil der Testwartung, da wir diese Tests auf dem neuesten Stand halten müssen.

- Leistungs- und Skalierbarkeitstests. Wir müssen prüfen, wie gut KI-Agenten unter verschiedenen Bedingungen arbeiten:

- Bei Leistungstests wird geprüft, wie schnell der Agent reagiert und wie viel er verarbeiten kann.

- Bei Skalierungstests wird geprüft, ob der Agent mehr Benutzer oder mehr Daten verarbeiten kann, ohne langsamer zu werden oder abzustürzen.

- UI- und API-Tests. KI-Agenten interagieren häufig mit Benutzern über eine Benutzeroberfläche (UI) oder mit anderer Software über eine Anwendungsprogrammierschnittstelle (API).

- Beim UI-Test wird geprüft, ob die Benutzeroberfläche einfach zu bedienen und zu verstehen ist.

- Beim API-Test wird geprüft, ob der Agent korrekt mit anderer Software kommuniziert.

- Unit-Tests. Bei dieser Technik werden kleine Teile des KI-Agenten isoliert getestet, um sicherzustellen, dass jede Komponente korrekt funktioniert.

- Benutzerakzeptanztests. Dies ist die letzte Testphase, in der der KI-Agent in einem realen Szenario getestet wird, um sicherzustellen, dass er die Anforderungen des Benutzers erfüllt.

- Systemtests. Dies beinhaltet das Testen des gesamten KI-Systems, einschließlich aller Komponenten und Integrationen.

- Testen von Agenten, die natürliche Sprache verarbeiten (NLP). Für KI-Agenten, die Sprache verstehen und verwenden, müssen wir einige spezifische Dinge testen:

- Kann der Agent verschiedene Akzente und Dialekte verstehen?

- Kann es mit Slang, grammatikalischen Fehlern und ungewöhnlichen Satzstrukturen umgehen?

- Kennt sie die Bedeutung hinter den Worten, nicht nur die Worte selbst?

Wir können die Leistung unserer KI-Agenten besser verstehen und potenzielle Probleme schneller erkennen, indem wir eine Kombination aus wirkungsvollen, spezifizierten Testverfahren einsetzen.

Unsere Kompetenz im Testen von AI-Agenten

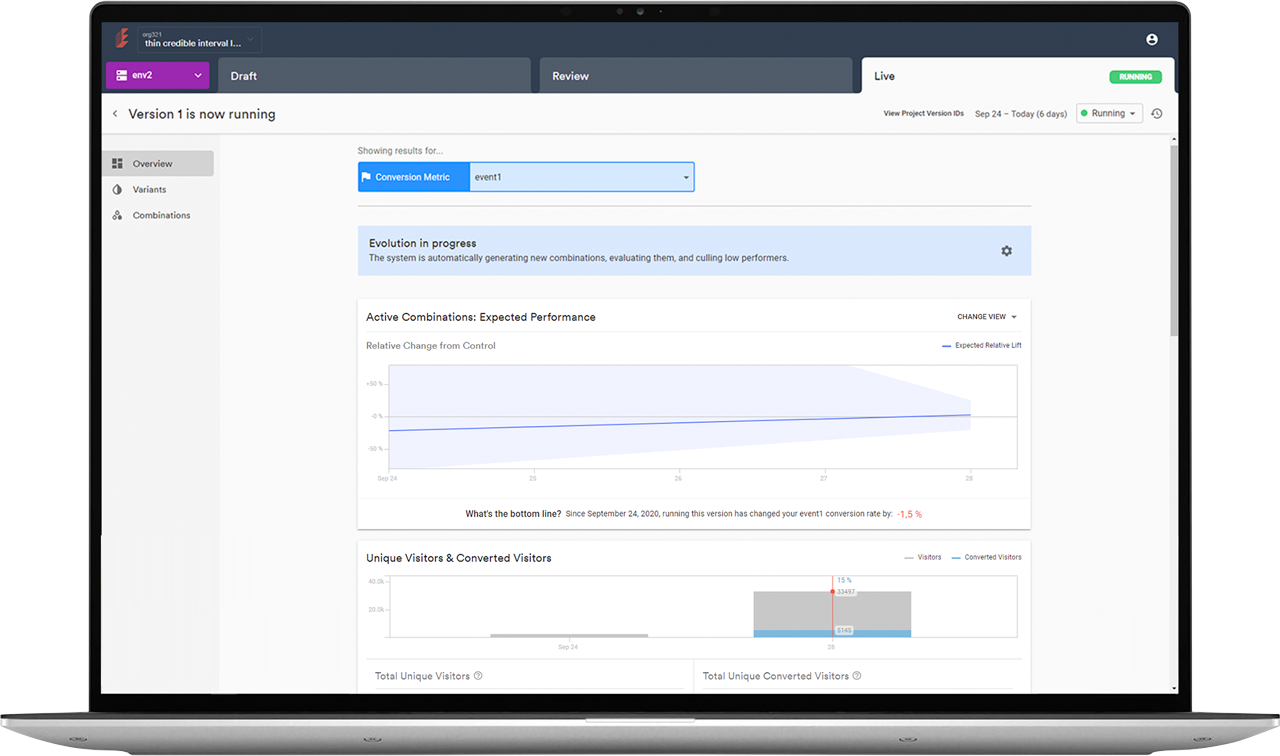

Da KI-Agenten immer stärker in unser Leben und unsere Unternehmen integriert werden, ist ein ausgewogener Testansatz, der die Stärken von manuellen und automatisierten Tests kombiniert, unerlässlich. Die Betonung kontinuierlicher Tests, die Priorisierung der Testabdeckung und die Verwendung realistischer Testdaten sind der Schlüssel zur Gewährleistung der Zuverlässigkeit, Sicherheit und des ethischen Verhaltens von KI. Genau diese Grundsätze haben uns bei der Qualitätssicherung für Evolv, einer KI-gestützten UX-Optimierungsplattform, geleitet.

Wir von QAwerk kennen die besonderen Herausforderungen beim Testen von KI-Agenten. Seit 2015 haben wir über 300 Produkte getestet. Um den Wert zu demonstrieren, den wir durch unseren sorgfältigen Ansatz bieten können, laden wir Sie ein, eine kostenlose Sondierungsrunde anzufordern und sich anderen innovativen KI-Startups anzuschließen, die kritische Probleme, die wir ans Licht gebracht haben, schnell gelöst haben. Hier sind einige Beispiele für kritische Fehler, bei deren Behebung wir ihnen geholfen haben:

- FYI.AI: Nachdem ein Benutzer das Feld “Suche” auf der Chatseite aktualisiert hat, werden keine Chats angezeigt.

- VisualMind: Die App stürzt ab, wenn ein Benutzer versucht, die E-Mail-Adresse aus dem Help Center zu kopieren.

- Dopple.AI: Benutzer können sich erfolgreich wieder bei Konten anmelden, die zuvor gelöscht wurden.

- Humango: KI-Schulungsplaner: Die Startseite wird blockiert (erfordert eine erneute Anmeldung), wenn Benutzer Karten in der Funktion “Neue Karte hinzufügen” ändern.

- Knowt – AI Flashcards & Notizen: Benutzer können sich nicht mit ihrem Google-Konto bei der App anmelden, da ein endloser Ladespinner angezeigt wird.

Möchten Sie die Qualität Ihres AI-Produkts verbessern? Kontaktieren Sie uns noch heute für ein kostenloses Beratungsgespräch, um Ihre QA-Anforderungen zu besprechen und zu erfahren, wie wir Ihnen bei der Verbesserung Ihrer Testabläufe helfen können.

Erfahren Sie, wie wir eine KI-Lösung für digitales Wachstum getestet und die Geschwindigkeit der Regressionstests um 50 % erhöht haben.

FAQ

Was ist der Unterschied zwischen KI-Testagenten und KI-Testagenten?

KI-Test-Agenten und KI-Test-Agenten klingen ähnlich, haben aber unterschiedliche Bedeutungen. KI-Testagenten sind KI-gestützte Software-Tools, die zum Testen anderer Software entwickelt wurden. Sie nutzen KI-Techniken, um den Testprozess für Anwendungen, Systeme oder Software zu automatisieren, zu verbessern und zu optimieren.

Das Testen von KI-Agenten bezieht sich auf die Bewertung der Qualität, Zuverlässigkeit und Sicherheit von KI-basierten Systemen oder Agenten. Dabei wird überprüft, ob das KI-System wie vorgesehen funktioniert und bestimmte Leistungskriterien erfüllt.

Wie können KI-Testagenten das Testen von Software verbessern?

KI-Testagenten verbessern das Testen von Software durch:

- Die Automatisierung sich wiederholender Aufgaben entlastet menschliche Tester

- Erhöhung der Testabdeckung durch verschiedene Szenarien

- Ermöglichung der frühzeitigen Fehlererkennung durch kontinuierliche Überwachung

- Verbesserung der Genauigkeit und Konsistenz, Reduzierung menschlicher Fehler

- Schnelleres Feedback für eine schnellere Problemlösung

- Intelligente Priorisierung von kritischen Testfällen

- Weniger Wartungsaufwand durch Selbstheilungstests

Was ist besser, manuelle Tests oder automatisierte Tests?

Der ideale Ansatz hängt von den spezifischen Testzielen und dem KI-Agenten ab. Manuelle Tests bewerten die Benutzererfahrung, erforschen unerwartete Szenarien und beurteilen subjektive Qualitäten. Automatisierte Tests sind effizienter für sich wiederholende Aufgaben, Regressionstests und umfangreiche Tests. Eine starke Teststrategie nutzt oft eine Mischung aus beiden Ansätzen.

In welchen Fällen ist das automatische Testen von KI-Agenten sinnvoller?

Automatisiertes Testen wird am meisten für Testfälle bevorzugt, die sind:

- Wiederholend: Fälle, die häufig ausgeführt werden müssen, wie z. B. Regressionstests.

- Zeitaufwendig: Fälle, die bei manueller Durchführung viel Zeit in Anspruch nehmen würden.

- Sie erfordern eine hohe Konsistenz: Fälle, in denen es entscheidend ist, jedes Mal die gleichen Ergebnisse zu erzielen.

- Groß angelegt: Fälle, in denen viele Varianten oder Kombinationen getestet werden müssen.

- Leistungsbezogen: Fälle, die Geschwindigkeit, Tragfähigkeit und Stabilität messen.